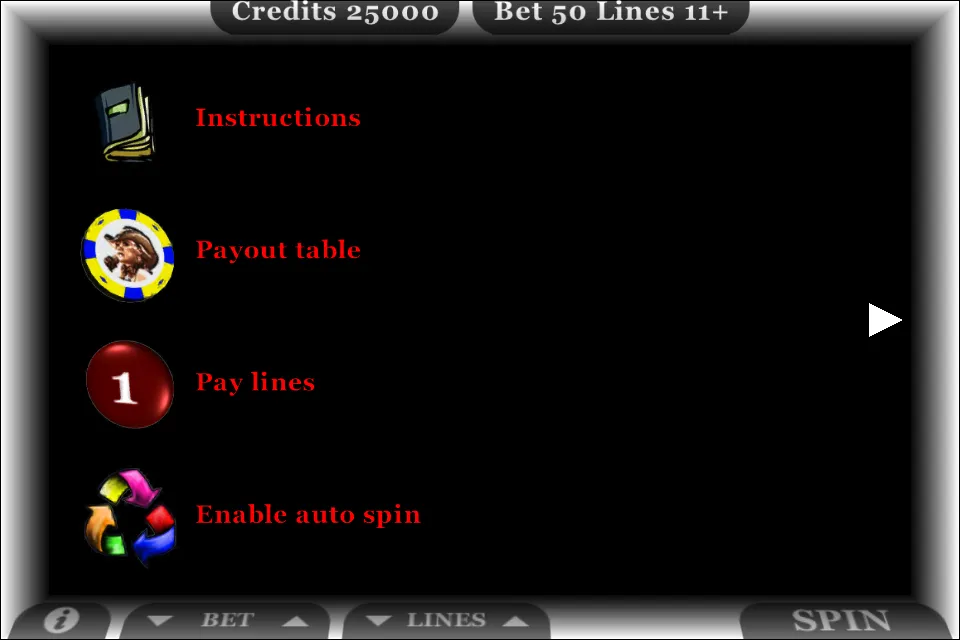

30 free slots

$1140

30 free slots,Junte-se à Hostess Popular Online para Desbloquear Estratégias Avançadas de Jogos, Garantindo Que Você Sempre Esteja Um Passo à Frente nos Desafios..Atende os Municípios de Novo Horizonte, Itajobi e Catanduva, e conta com um acesso ao Distrito de Roberto (Pindorama) e ao Bairro Km 7 e o Bairro Km 10, Ambos em Catanduva.,Para evitar conteúdos indesejáveis nos índices de busca, os ''webmasters'' podem instruir os ''spiders'' a não rastrearem certos arquivos ou diretórios através do arquivo robots.txt padrão no diretório raiz do domínio. Além disso, uma página pode ser explicitamente excluída do banco de dados de um mecanismo de busca usando uma meta''-tag'' específica para robôs (geralmente, ). Quando um mecanismo de busca visita um ''site'', o arquivo robots.txt localizado no diretório raiz é o primeiro arquivo a ser rastreado. O arquivo robots.txt é então analisado e instruirá o robô quanto às páginas que não devem ser rastreadas. Como um motor de busca pode manter uma cópia deste arquivo em cache, ele pode ocasionalmente rastrear páginas que um ''webmaster'' não deseja rastrear. As páginas normalmente impedidas de serem rastreadas incluem páginas específicas de ''login'', como carrinhos de compras e conteúdo específico do usuário, como resultados de buscas internas. Em março de 2007, o Google avisou aos ''webmasters'' que eles deveriam impedir a indexação de resultados de buscas internas porque essas páginas são consideradas ''spam'' de busca. Em 2020, o Google colocou em prática o padrão (e abriu seu código) e agora o trata como uma dica e não como uma diretiva. Para garantir adequadamente que as páginas não sejam indexadas, a meta-''tag'' de um robô de nível de página deve ser incluída..

- SKU: 176

- Danh mục: 2 exercito

- Tags: expresso brasileiro site

Descrever

30 free slots,Junte-se à Hostess Popular Online para Desbloquear Estratégias Avançadas de Jogos, Garantindo Que Você Sempre Esteja Um Passo à Frente nos Desafios..Atende os Municípios de Novo Horizonte, Itajobi e Catanduva, e conta com um acesso ao Distrito de Roberto (Pindorama) e ao Bairro Km 7 e o Bairro Km 10, Ambos em Catanduva.,Para evitar conteúdos indesejáveis nos índices de busca, os ''webmasters'' podem instruir os ''spiders'' a não rastrearem certos arquivos ou diretórios através do arquivo robots.txt padrão no diretório raiz do domínio. Além disso, uma página pode ser explicitamente excluída do banco de dados de um mecanismo de busca usando uma meta''-tag'' específica para robôs (geralmente, ). Quando um mecanismo de busca visita um ''site'', o arquivo robots.txt localizado no diretório raiz é o primeiro arquivo a ser rastreado. O arquivo robots.txt é então analisado e instruirá o robô quanto às páginas que não devem ser rastreadas. Como um motor de busca pode manter uma cópia deste arquivo em cache, ele pode ocasionalmente rastrear páginas que um ''webmaster'' não deseja rastrear. As páginas normalmente impedidas de serem rastreadas incluem páginas específicas de ''login'', como carrinhos de compras e conteúdo específico do usuário, como resultados de buscas internas. Em março de 2007, o Google avisou aos ''webmasters'' que eles deveriam impedir a indexação de resultados de buscas internas porque essas páginas são consideradas ''spam'' de busca. Em 2020, o Google colocou em prática o padrão (e abriu seu código) e agora o trata como uma dica e não como uma diretiva. Para garantir adequadamente que as páginas não sejam indexadas, a meta-''tag'' de um robô de nível de página deve ser incluída..